di Teresa Numerico

«Nel paese degli algoritmi» di Aurélie Jean, per Neri Pozza. Una parola aleggia al centro del testo: interpretazione. Non tutto può essere infatti oggetto di astrazione perché incide sulla vita reale delle persone

Aurélie Jean non corrisponde alla rappresentazione classica del nerd che scrive algoritmi per la simulazione scientifica, eppure lo è. Si dedica anche alla divulgazione e ha pubblicato un libro, da poco tradotto in italiano. Nel paese degli algoritmi (Neri Pozza, pp. 173, euro 17) è in un certo senso una sua biografia intellettuale. Descrive come abbia cominciato a fare modelli algoritmici professionali misurando l’elasticità delle gomme delle automobili. Ha poi lavorato a calcolare il rischio, anche indiretto, di un trauma cranico in presenza di un’esplosione, a fare previsioni algoritmiche sul mercato azionario per conto di Bloomberg, ha contribuito a una ricerca per simulare lo sviluppo di cellule cardiache in vitro. Attraversando vari campi ha sperimentato alcune criticità dei meccanismi algoritmici. Ritiene, quindi, che ci sia bisogno di una riflessione epistemologica ed etica.

Una parola aleggia non molto pronunciata, ma incontrovertibilmente al centro del suo progetto: interpretazione. Quando si modella un fenomeno si devono prendere delle decisioni, relative alla sua formulazione matematica. Queste interpretazioni o semplificazioni richiedono l’uso di bias, meccanismi di discriminazione, o pregiudizi, che possono essere espliciti, ovvero adottati consapevolmente dal programmatore, o impliciti, espressi indirettamente nel codice o annidati nei dati per addestrare l’algoritmo a comprendere il fenomeno, oppure relativi alla valutazione dell’output della simulazione. Tali bias sono inevitabilmente soggettivi, cioè costituiscono una ricostruzione situata del fenomeno da modellare. Ogni simulazione, quindi, implica uno sguardo, un vincolo percettivo e cognitivo di chi la esercita.

Il processo di astrazione guarda le situazioni da più lontano e le raggruppa in cluster, discriminando tra loro in merito a somiglianze e differenze. Tuttavia, questo meccanismo – proprio della conoscenza per astrazione, non solo algoritmica – nel caso degli algoritmi si inabissa nella tecnicalità della programmazione che opacizza la consapevolezza del loro carattere soggettivo, valutativo e incerto.

La definizione dei criteri di astrazione avviene lontano da dove si manifestano i suoi effetti. Ma i vincoli pregiudiziali di chi scrive i programmi e mette insieme i dati di training producono conseguenze concrete per le persone a cui quei modelli si applicano. La procedura algoritmica, infatti, si nutre di astrazioni sui dati, ma ha effetto sulle persone quando le decisioni poi pesano sulla quantificazione del premio assicurativo, sulla definizione dei protocolli di cura che li riguardano, sulla valutazione relativa alla libertà condizionata, sulla possibilità che il proprio curriculum sia selezionato, ecc.

Jean è molto consapevole dei rischi, ma tentenna quando si tratta di definire i limiti degli strumenti tecnici. Attribuisce alle persone che li programmano la responsabilità di includere i loro pregiudizi nel codice, e ha ragione.

Ma non basta. I sistemi complessi e automatizzati sono rigidi e opachi per costituzione, e questo impatta sulla loro potenziale iniquità. La sua analisi, a tratti, si rifugia nel soluzionismo tecnologico, pur raffinato.

In certe situazioni complesse dove gli interessi in gioco sono tanti e contrapposti – come di solito nella vita reale delle persone – non esiste una soluzione ottimale dei problemi politici e sociali. Pensare di costruire un algoritmo a cui appaltare la decisione, anche con le migliori intenzioni, non è una buona strategia – nemmeno se i programmatori sono morali e consapevoli. Automatizzare le procedure di valutazione non può essere una scusa per neutralizzare lo sguardo di chi le determina e occultarne il potere.

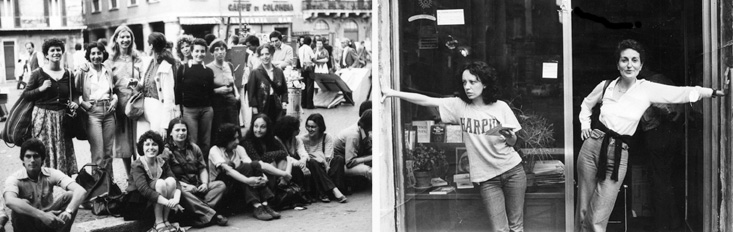

L’apparato tecnico è di per sé un’incarnazione di un sistema di potere-sapere che esercita gli interessi di chi ne è in controllo, che sono spesso un gruppo ristretto e coeso di maschi bianchi addestrati nelle migliori università private english-speaking. Non è un caso che ad accorgersi delle contraddizioni sia una donna francese, sebbene educata in matematica computazionale, che – come dichiara – non rientra nelle categorie prevedibili. Il suo bagaglio di conoscenze implicite, trasversali le offre la cultura per riconoscere i problemi irrisolti.

Ma bisogna fare in fretta perché l’omologazione culturale è imperante anche nell’ambito dell’educazione. La brama di internazionalizzare la conoscenza – da intendere come colonialismo culturale anglofono dell’università in tutto l’occidente – mette il pluralismo a rischio. La diversità non è un progetto di assunzione nella Silicon Valley, le cui aziende dovrebbero scegliere più donne, più afroamericani o latini, più persone dall’identità sessuale o etnica ibrida, ma accettare di prendere in considerazione modi alternativi di pensare, la varietà dei giudizi e di riconoscere la singolarità delle condizioni delle persone.

Razzismo e discriminazione sono invece l’effetto di meccanismi di generalizzazione avvenuti in modo superficiale e scorretto, dentro un contesto chiuso, privo di contraddittorio. Non tutto può essere oggetto di astrazione, senza condurre a esiti iniqui.

(il manifesto, 10 marzo 2021)